Si une voiture autonome devait faire un accident inévitable, qui faudrait-il sacrifier en priorité ?

Si une voiture autonome devait faire un accident inévitable, qui faudrait-il sacrifier en priorité ?Le MIT livre les résultats de son étude éthique

Avec le développement rapide de l'intelligence artificielle sont nées des inquiétudes sur l'éthique des décisions que devront prendre les dispositifs intelligents. En ce qui concerne les voitures autonomes par exemple, l'une des applications les plus importantes de l'IA, les chercheurs du MIT ont essayé d'avoir une réponse à une question cruciale : si une voiture autonome devait faire un accident inévitable, qui faudrait-il sacrifier en priorité ?

C'est bien le fameux dilemme du tramway dont la version originale peut se formuler comme suit : imaginons le conducteur d'un tramway hors de contrôle qui se doit de choisir sa course entre deux voies possibles : cinq hommes travaillent sur la première voie et un homme est situé sur l'autre. La voie prise par le tramway entraînera automatiquement la mort des personnes qui s'y trouvent. Que faut-il faire alors ? Prendre la deuxième voie afin de sacrifier une seule vie pour en sauver cinq ? Mais ce choix est-il vraiment moral ?

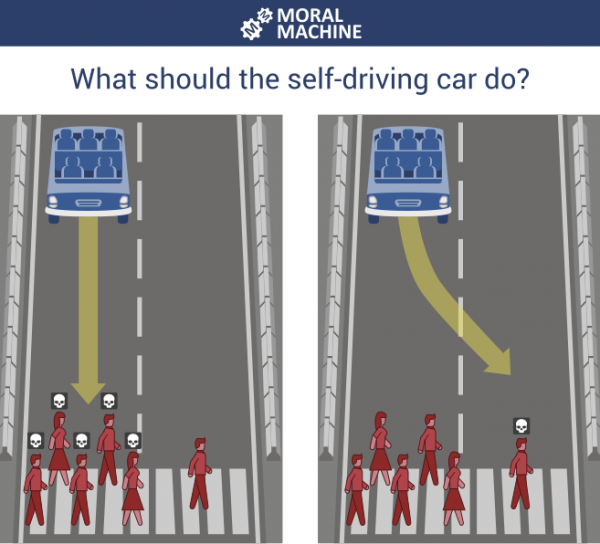

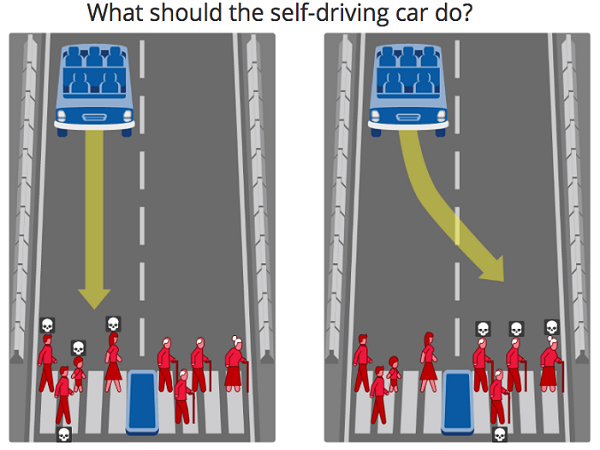

Les chercheurs du MIT Media Lab se sont inspirés de ce problème classique pour tester neuf différentes situations : la voiture autonome devrait-elle épargner en priorité les humains plutôt que les animaux de compagnie, les passagers au lieu des piétons, les femmes au lieu des hommes, les jeunes plutôt que les vieux, les personnes ayant un haut statut social au lieu de celles ayant un statut inférieur, les personnes respectant la loi plutôt que les criminels, les personnes mal portantes au lieu de celles en bonne santé ? La voiture devrait-elle dévier (agir) ou ne rien faire ou encore chercher à épargner le plus de vies possible ?

Pour cela, ils ont conçu en 2014 une expérience qu'ils ont appelée Moral Machine, une plateforme qui leur a permis de recueillir les avis du public sur ce qu'il faut sacrifier ou épargner en priorité si une voiture autonome devait faire un crash inévitable. Mais plutôt que de proposer des comparaisons individuelles, l’expérience a présenté aux participants diverses combinaisons. Quatre ans après la mise en ligne de la plateforme, des millions de personnes dans 233 pays et territoires ont permis d'enregistrer 40 millions de décisions morales, ce qui en fait l'une des plus grandes études jamais réalisées sur les préférences morales mondiales.

Un nouvel article publié dans la revue scientifique Nature présente l'analyse de ces données. L'étude révèle que dans l'ensemble, les gens sont d’accord pour épargner les humains plutôt que les animaux ou encore préserver la vie des enfants en priorité plutôt que celle des adultes. Sans surprise, le gens estiment aussi qu'il faut privilégier le scénario le moins coûteux en nombre de vies.

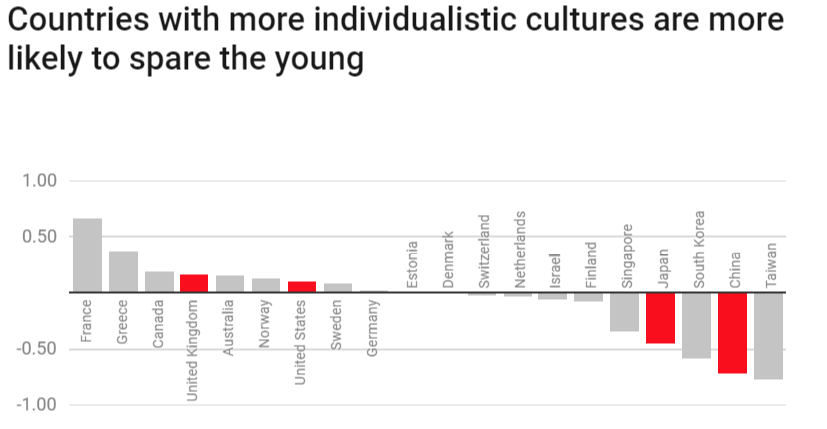

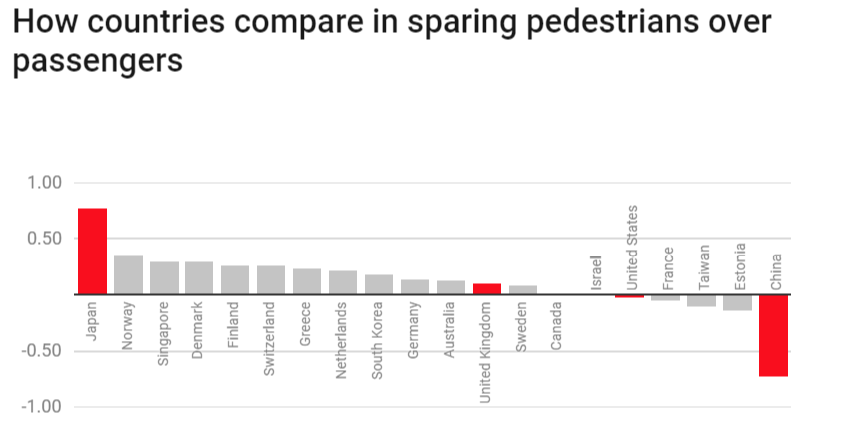

Il y a toutefois des divergences notables en fonction de la culture, de l'économie et de la localisation géographique. L'étude montre par exemple que les pays ayant des cultures plus individualistes sont les plus susceptibles d'épargner les jeunes plutôt que les vieux - et la France arrive en tête dans ce groupe de pays. Mais à l'opposé, les participants de cultures collectivistes comme la Chine et le Japon sont moins enclins à épargner les jeunes au détriment des plus âgés. Les chercheurs supposent que c'est probablement en raison de l'importance accrue accordée au respect des personnes âgées dans ces pays. C'est ce qui est illustré par la figure suivante qui compare les pays qui testent les voitures autonomes : un score plus proche de 1 signifie que les répondants sont plus d'accord pour épargner les jeunes au lieu des plus âgés. Et un score plus proche de -1 signifie que les répondants sont plus favorables au fait de préserver la vie des personnes âgées ; 0 étant la moyenne mondiale.

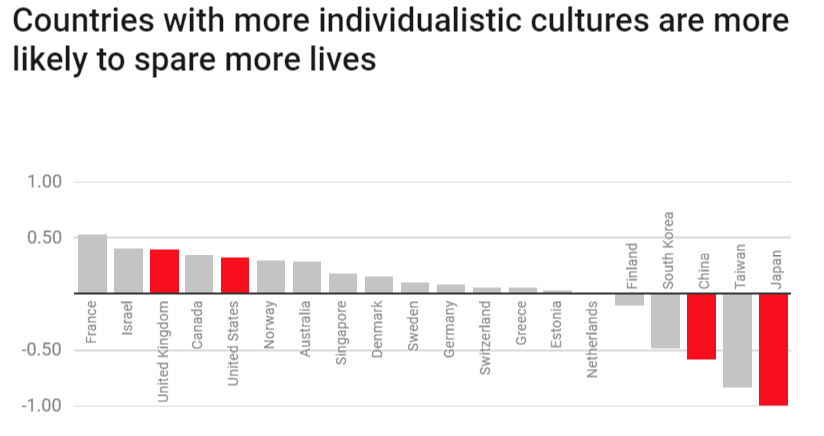

Les résultats ont également montré que les participants de cultures individualistes, comme le Royaume-Uni et les États-Unis, étaient plus d'accord pour épargner plus de vies étant donné tous les autres choix. La France est également en tête de ce groupe, comme le montre la figure ci-dessous. Plus le score est proche de 1, plus les répondants estiment qu'il faut épargner davantage de vies. Plus le score est proche de -1, moins les répondants insistent sur le fait d'épargner davantage de vies ; 0 étant la moyenne mondiale.

De même, les participants des pays pauvres dotés d'institutions plus faibles sont plus tolérants à l'égard des piétons qui marchent sur la chaussée quand il s'agit de choisir entre eux et les piétons qui traversent légalement. Et les participants des pays avec un niveau élevé d'inégalité économique montrent des écarts plus grands entre le traitement des individus avec un statut social élevé et ceux ayant un statut bas.

Faut-il épargner les piétons plutôt que les passagers ? C'était également une question importante dont la réponse varie en fonction des pays. Le Japon s'est classé comme étant le premier pays où les répondants préfèrent que la vie des piétons soit épargnée au détriment de la vie des passagers. A l'opposé du Japon, on retrouve la Chine où les répondants ont clairement fait savoir qu'ils préfèrent plutôt qu'on épargne la vie des passagers, et donc qu'on risque la vie des piétons si nécessaire. Par rapport à la moyenne mondiale, la France penche du côté de ceux qui veulent qu'on épargne la vie des passagers plutôt que la vie des piétons.

L'étude a des implications intéressantes pour les pays qui testent actuellement des voitures autonomes, car ces préférences pourraient jouer un rôle dans la conception et la réglementation de ces véhicules. Les constructeurs automobiles peuvent par exemple constater que les consommateurs chinois entreraient plus facilement dans une voiture qui les protège au détriment des piétons. Mais les auteurs de l'étude ont souligné que les résultats ne sont pas censés dicter la manière dont les différents pays doivent agir. D'ailleurs, dans certains cas, les auteurs ont estimé que les technologues et les décideurs ne devraient pas tenir compte de l'opinion publique collective.

À propos de la décision morale en fonction du statut social par exemple, « il est inquiétant que les gens aient trouvé, à un degré significatif, qu'il est bon d'épargner les personnes ayant un statut social élevé au détriment de ceux ayant un statut inférieur », affirme Edmond Awad, l'un des auteurs de l'étude. Il estime donc que les résultats devraient plus être utilisés par l'industrie et le gouvernement comme base pour comprendre comment le public réagirait à l’éthique de différentes décisions de conception et de politique.

Enfin, notons que cette étude n'est pertinente que si l'objectif est de commencer dès maintenant à discuter de ce qui pourrait être un problème dans 10 ou 20 ans. En effet, les voitures autonomes ne sont pas aussi autonomes et performantes actuellement pour identifier toutes les caractéristiques des objets ou humains qui entrent dans leur champ de vision. Parce que distinguer un jeune d'une personne âgée ou encore un criminel d'une personne respectant la loi ne demande pas juste d'être doté de capteurs sophistiqués, mais de disposer d'un véritable système de reconnaissance faciale et toute l'infrastructure qui va avec.

Sources : MIT Technology Review, The Moral Machine (les différents scénarios)

Et vous ?

Que pensez-vous des résultats de cette étude ? Quels sont les problèmes qu’elle met en évidence ?

Que pensez-vous des résultats de cette étude ? Quels sont les problèmes qu’elle met en évidence ? Qui faut-il sacrifier en priorité si une voiture autonome devait faire un accident inévitable ?

Qui faut-il sacrifier en priorité si une voiture autonome devait faire un accident inévitable ?

Vous avez lu gratuitement 684 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

.

.