L'intelligence artificielle est de plus en plus présente dans notre quotidien et, dans certains pays, est déjà placée au cœur de certains métiers pour faciliter la prise de décision. Il y a en effet des décisions dans le monde réel qui peuvent changer le cours de la vie d'une personne (dans la santé, le système judiciaire, etc.) et dans lesquelles interviennent des algorithmes de machine learning. Mais qu'à quel point doit-on faire confiance à une IA ?

L'intelligence artificielle est de plus en plus présente dans notre quotidien et, dans certains pays, est déjà placée au cœur de certains métiers pour faciliter la prise de décision. Il y a en effet des décisions dans le monde réel qui peuvent changer le cours de la vie d'une personne (dans la santé, le système judiciaire, etc.) et dans lesquelles interviennent des algorithmes de machine learning. Mais qu'à quel point doit-on faire confiance à une IA ?Cette question est assez pertinente dans la mesure où il existe des recherches qui ont montré l'existence de biais dans certains algorithmes de machine learning qui, dans certains cas, peuvent entraîner des discriminations à l'égard de certaines personnes. Les exemples concrets ne manquent pas.

En 2016 par exemple, il a été découvert que Compas, le logiciel de North Pointe (aux USA), qui utilise le machine learning pour prédire si un accusé commettra de futurs crimes, juge les Noirs plus sévèrement que les Blancs. À titre d'exemples, Propublica, le média qui relatait l'affaire a révélé que deux personnes arrêtées pour possession de drogue, l'une (un homme blanc) a été classée comme étant à faible risque (niveau 3/10), alors que l'autre (un homme noir) a été classée comme étant à risque élevé (niveau 10/10). Le premier a pourtant été coupable de la même infraction trois fois plus tard, contrairement à l'autre accusé qui n'a été coupable d'aucune infraction plus après sa libération.

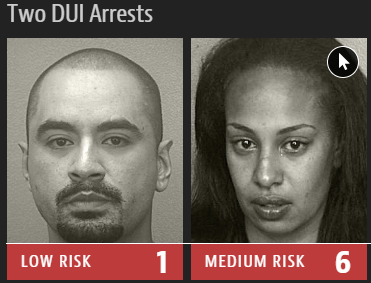

C'était une situation similaire pour deux personnes arrêtées pour conduite en état d'ivresse (DUI). L'une d'entre elles (un homme blanc) avec déjà quatre infractions à son actif a été jugée moins risquée (1/10), alors que l'autre (une femme noire) avec une seule infraction à son actif a été jugée plus risquée (6/10).

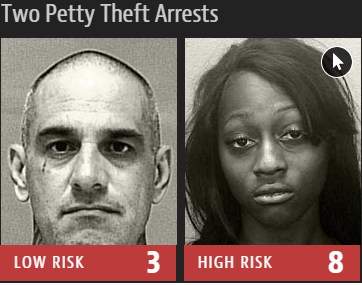

Le biais est encore plus évident en comparant les scores de deux personnes arrêtées pour vol. L'une a été évaluée à haut risque (8/10) de commettre un futur crime après qu'elle et un ami ont volé un vélo et un scooter qui étaient stationnés dehors. Elle n'a pourtant pas récidivé, alors qu'un autre arrêté pour vol a été classé à faible risque (3/10), bien qu'il ait à son actif deux vols à main armée et une tentative de vol à main armée. Et il a commis un autre grand vol après sa libération.

Ce n'est pas le seul exemple de biais dans les algorithmes de machine learning. Des recherches de Boston University et de Microsoft ont aussi montré que les jeux de données utilisés pour entrainer les programmes d'intelligence artificielle contiennent des connexions sémantiques sexistes, en considérant par exemple le mot « programmeur » plus proche du mot « homme » que du mot « femme ». Et une autre étude menée par le Media Lab du MIT montre que les algorithmes de reconnaissance faciale ont jusqu'à 12 % plus de risques d'identifier à tort les mâles à la peau foncée que les mâles à la peau claire. De toute évidence, il peut y avoir un biais dans un algorithme de machine learning résultant tout simplement des données sur lesquelles il a été construit. Et dans certains cas, les conséquences de ce biais peuvent être très graves.

Aujourd'hui, les grandes entreprises de haute technologie - y compris Microsoft, Google et Amazon - se battent pour vendre des technologies de machine learning disponibles dans le cloud. Comme de plus en plus de clients utilisent ces algorithmes pour automatiser des décisions importantes, il existe un risque que les biais soient automatisés, déployés à grande échelle et plus difficiles à repérer pour les victimes. La question du biais dans les algorithmes deviendra donc cruciale, ce qui pousse de nombreux chercheurs et experts en technologie à s'y pencher maintenant. Fournir des moyens d'automatiser la détection de biais algorithmiques pourrait donc devenir un élément clé de boîtes à outils d'IA.

Microsoft fait partie des entreprises qui travaillent pour trouver une solution à ce problème. En effet, le géant du logiciel est en train de créer un outil permettant d'identifier automatiquement les biais dans différents algorithmes pour permettre aux entreprises d'utiliser l'IA sans discriminer par inadvertance certaines personnes.

« Des choses comme la transparence, l'intelligibilité et l'explication sont si récentes dans le domaine que peu d'entre nous ont suffisamment d'expérience pour savoir tout ce que nous devrions rechercher et toutes les façons dont ces biais pourraient se cacher dans nos modèles », explique Rich Caruna, un chercheur de Microsoft travaillant sur ce projet.

Caruna estime que le produit de détection de biais de Microsoft aidera les chercheurs en IA à identifier plus de cas d'injustice, mais pas tous. « Bien sûr, nous ne pouvons pas nous attendre à la perfection - il y aura toujours un biais non détecté ou qui ne peut être éliminé - le but est de faire aussi bien que possible », dit-il. « La chose la plus importante que les entreprises peuvent faire en ce moment est d'éduquer leurs employés afin qu'ils soient conscients de la myriade de biais qu'il peut y avoir et créer des outils pour faciliter la compréhension des modèles et les détecter », a-t-il ajouté, en faisant probablement allusion aux autres géants de la technologie dans la course à l'intelligence artificielle.

À propos, précisons que Facebook a annoncé son propre outil de détection des biais lors de sa conférence annuelle des développeurs le 2 mai. Son outil, baptisé Fairness Flow, peut mesurer les biais potentiels en faveur ou au détriment de certains groupes de personnes. Il avertit automatiquement si un algorithme porte un jugement injuste sur quelqu'un en fonction de sa race, son sexe ou son âge. Comme Microsoft, Facebook estime qu'il faut plus d'équité étant donné que de plus en plus de gens utilisent l'IA pour prendre des décisions importantes.

Certains observateurs ne sont toutefois pas satisfaits des outils annoncés par Microsoft et Facebook. C'est le cas par exemple de Bin Yu, professeur à l'UC Berkeley. Si elle affirme que les outils de Facebook et Microsoft semblent être un pas dans la bonne direction, elle estime qu'ils ne sont peut-être pas suffisants. Elle pense plutôt que les grandes entreprises devraient faire vérifier leurs algorithmes par des experts externes afin de prouver qu'ils ne sont pas biaisés. « Quelqu'un d'autre doit enquêter sur les algorithmes de Facebook, ils ne peuvent pas être un secret pour tout le monde », a-t-elle dit.

Sources : MIT Technology Review, Propublica (2016), Recherche de Boston University (2016), MIT Media Lab

Et vous ?

Que pensez-vous des biais dans les algorithmes d'intelligence artificielle ?

Que pensez-vous des biais dans les algorithmes d'intelligence artificielle ? Qu'en est-il de la solution de Microsoft ? Un pas dans la bonne direction ?

Qu'en est-il de la solution de Microsoft ? Un pas dans la bonne direction ? Faut-il plutôt inspecter les algorithmes d'IA des grandes entreprises comme le suggère Bin Yu ?

Faut-il plutôt inspecter les algorithmes d'IA des grandes entreprises comme le suggère Bin Yu ? Doit-on limiter les domaines d’utilisation de l’IA ? Si oui, dans quels domaines préférez-vous que l’IA ne soit pas utilisée actuellement ?

Doit-on limiter les domaines d’utilisation de l’IA ? Si oui, dans quels domaines préférez-vous que l’IA ne soit pas utilisée actuellement ?Voir aussi :

USA : des associations s'érigent contre la technologie de reconnaissance faciale d'Amazon, craignant une surveillance de masse par la police

USA : des associations s'érigent contre la technologie de reconnaissance faciale d'Amazon, craignant une surveillance de masse par la police Intelligence artificielle: une vingtaine d'experts plaident pour la création d'un laboratoire européen en IA, afin de concurrencer les USA et la Chine

Intelligence artificielle: une vingtaine d'experts plaident pour la création d'un laboratoire européen en IA, afin de concurrencer les USA et la Chine USA : le sous-secrétaire à la défense soulève l'importance d'associer l'intelligence artificielle à l'armée évoquant une future course aux armes

USA : le sous-secrétaire à la défense soulève l'importance d'associer l'intelligence artificielle à l'armée évoquant une future course aux armes L'EFF appelle à ne pas utiliser l'intelligence artificielle pour la guerre s'adressant à Google et aux entreprises de l'IA

L'EFF appelle à ne pas utiliser l'intelligence artificielle pour la guerre s'adressant à Google et aux entreprises de l'IA Les chercheurs en intelligence artificielle peuvent-ils gagner jusqu'à 1 million $ par an dans la Silicon Valley ? Un aperçu des salaires

Les chercheurs en intelligence artificielle peuvent-ils gagner jusqu'à 1 million $ par an dans la Silicon Valley ? Un aperçu des salaires