Google publie l'API TensorFlow Object Detection pour faciliter l'identification des objets dans les images

Google publie l'API TensorFlow Object Detection pour faciliter l'identification des objets dans les images aux développeurs

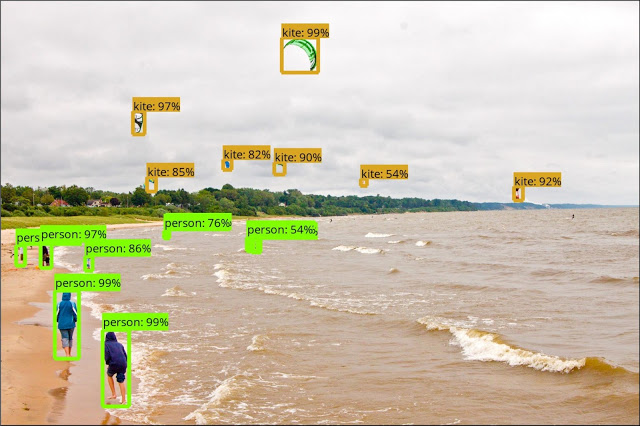

Google publie une nouvelle API de détection d'objets TensorFlow pour faciliter aux développeurs et chercheurs l’identification des objets dans les images. L'API TensorFlow Object Detection est un framework open source intégré à TensorFlow qui permet de construire, de former et de déployer facilement des modèles de détection d'objets, conçu pour supporter des modèles à la fine pointe de la technologie tout en permettant une exploration et une recherche rapides.

« Chez Google, nous développons des systèmes d'apprentissage machine (AM) à la fine pointe de la technologie pour une vision par ordinateur qui, non seulement peuvent être utilisés pour améliorer nos produits et nos services, mais également stimuler les progrès dans le milieu de la recherche. La création de modèles AM précis, capables de localiser et d'identifier de multiples objets dans une seule image, reste un défi majeur dans le domaine, et nous investissons beaucoup de temps dans la formation et l’expérimentation de ces systèmes », ont expliqué Jonathan Huang, Research Scientist et Vivek Rathod, Ingénieur logiciel.

Les collègues indiquent qu’en octobre dernier, ce système interne de détection d'objets a permis d'obtenir de meilleurs résultats et a obtenu la première place dans un défi de détection COCO (Common Objects in Context). Depuis lors, ce système a été évoqué par un certain nombre de publications de recherche et a été implémenté dans des produits Google tels que NestCam, les éléments similaires et les idées de style dans Recherche d'images et Numéro de rue ainsi que la détection de nom dans Street View.

Pour rappel, depuis le mois d’avril, Google a lancé la fonctionnalité « style idea » dans son application de recherche d’image sur Android pour inspirer les utilisateurs et leur proposer une grille d'images et de tenues de style de vie qui montrent comment le produit de leur choix peut être porté dans la vie réelle. « Avec “idées de style”, vous pouvez voir les options de la vie réelle de ce à quoi le sac et le jeans ont l'air avec ces talons hauts rouges que vous avez regardés. »

« En prime, vous verrez également un carrousel élargi pour des "articles similaires" lors de la recherche de produits d'habillement. Cela signifie que si vous recherchez des shorts et des baskets ou alors des lunettes de soleil et des sacs à main, vous pourrez trouver des offres de produits qui conviennent à vos goûts. La découverte d'une option de négociation sans sacrifier le style est désormais accessible depuis la recherche d'image. »

« Aujourd'hui, nous sommes heureux de mettre ce système à la disposition de la communauté de recherche plus large via l'API TensorFlow Object Detection », se sont-ils réjouis. « Nos objectifs dans la conception de ce système étaient de soutenir les modèles à la fine pointe de la technologie tout en permettant une exploration et une recherche rapides », ont-ils continué.

Cette première version contient une sélection de modèles de détection qui peuvent apprendre, parmi lesquels :

- Single Shot Multibox Detector (SSD) avec MobileNets ;

- SSD avec Inception V2 ;

- Region-Based Fully Convolutional Networks (R-FCN) avec Resnet 101 ;

- Faster RCNN avec Resnet 101 ;

- Faster RCNN avec Inception Resnet v2.

Google assure que les modèles SSD qui utilisent MobileNet sont légers, de sorte qu'ils peuvent être exécutés de manière confortable en temps réel sur des appareils mobiles.

Cette première version contient également un cahier Jupyter pour effectuer des inférences prêtes à l'emploi avec l'un des modèles publiés par Google. Les collègues indiquent qu’elle s’accompagne également des scripts de formation locaux pratique ainsi que des pipelines de formation et d'évaluation distribués via Google Cloud.

Source : Google

Vous avez lu gratuitement 667 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.