Les processeurs actuels sont principalement limités par leur consommation énergétique : il n’est pas possible de garder tous les transistors d’une même puce allumés simultanément, car la densité d’énergie est beaucoup trop importante — chaque millimètre carré consomme trop d’énergie, la puce brûlerait à coup sûr sans désactiver des parties. Ce phénomène a conduit à la notion de silicium noir, c’est-à-dire les parties qui ne peuvent pas être utilisées à un instant donné dans un processeur. Un domaine de recherche dans les semiconducteurs concerne donc la création de transistors qui consomment nettement moins d’énergie (et donc dissipent moins de chaleur).

Les processeurs actuels sont principalement limités par leur consommation énergétique : il n’est pas possible de garder tous les transistors d’une même puce allumés simultanément, car la densité d’énergie est beaucoup trop importante — chaque millimètre carré consomme trop d’énergie, la puce brûlerait à coup sûr sans désactiver des parties. Ce phénomène a conduit à la notion de silicium noir, c’est-à-dire les parties qui ne peuvent pas être utilisées à un instant donné dans un processeur. Un domaine de recherche dans les semiconducteurs concerne donc la création de transistors qui consomment nettement moins d’énergie (et donc dissipent moins de chaleur).En 1961, des chercheurs d’IBM ont déterminé une limite absolue dans la consommation d’énergie d’un transistor (la limite de Landauer) : en effet, d’un point de vue thermodynamique, la bascule d’un transistor n’est pas réversible, ce qui s’accompagne inévitablement de pertes d’énergie (en application de la seconde loi de la thermodynamique). Cette valeur a été déterminée comme trois zeptojoules (3 10^-21 joules). A contrario, des transistors actuels optimisés pour la consommation d’énergie se placent au niveau de la picojoule, c’est-à-dire 10^-12 joules, soit un milliard de fois plus que le minimum théorique (!), pour la réalisation de puces mémoire magnétiques par transfert de spin (STT-MRAM). Les transistors plus courants consomment encore plus d’énergie.

En 2012, une équipe allemande a, pour la première fois, démontré expérimentalement que cette limite inférieure de consommation pouvait être atteinte. Ils ont, pour ce faire, utilisé une pince optique pour déplacer des perles de verre de deux microns de large (similaires à des bits) entre deux puits de potentiel. Une équipe américaine vient de montrer un résultat similaire, mais bien plus directement applicable à l’électronique : ils ont directement manipulé des bits faits d’aimants à l’échelle nanométrique. Ce genre d’aimants est déjà à la base des disques durs magnétiques actuels, mais également des mémoires de type STT-MRAM.

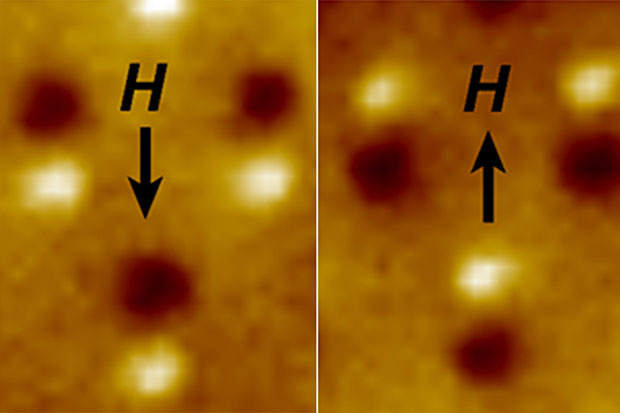

Des aimants nanométriques stockent l’information par la direction du champ magnétique de l’aimant. Avec un champ magnétique externe, les chercheurs ont pu inverser l’orientation du champ des aimants. En mesurant très précisément l’intensité et l’orientation du champ de l’aimant en fonction du champ extérieur, ils ont pu déterminer que cette opération consommait en moyenne six zeptajoules à température ambiante, soit le double de la limite de Landauer (sans compter, donc, la génération du champ utilisé pour manipuler les aimants). L’équipe estime que la différence par rapport à la limite théorique est principalement due à de légères variations dans l’orientation des nanoaimants : en effet, selon des simulations numériques, des nanoaimants idéaux atteignent exactement cette limite.

Cependant, ces progrès n’auront aucun impact sur les transistors utilisés dans les processeurs grand public à court terme, ni probablement à moyen terme : cette expérience marque un pas dans le passage entre la recherche fondamentale en physique et la recherche appliquée dans les transistors, mais il reste encore de nombreuses années avant une arrivée sur le marché.

Source (y compris l’image) et plus de détails : Zeptojoule Nanomagnetic Switch Measures Fundamental Limit of Computing.

Ce contenu a été publié dans Matériel par dourouc05.

) ?

) ?