BitTorrent veut faire du P2P (peer-to-peer) un élément essentiel du Web. La société à l’origine du célèbre protocole décentralisé de transfert de données diversifie ses services, tout en restant sur l’idée de base qui a fait son succès.

BitTorrent veut faire du P2P (peer-to-peer) un élément essentiel du Web. La société à l’origine du célèbre protocole décentralisé de transfert de données diversifie ses services, tout en restant sur l’idée de base qui a fait son succès.Après sa messagerie sécurisée Bleep basée sur une technologie distribuée pour les échanges et son outil de synchronisation de fichiers Sync, reposant toujours sur un modèle P2P, la société californienne dévoile sa prochaine innovation : Maelstrom.

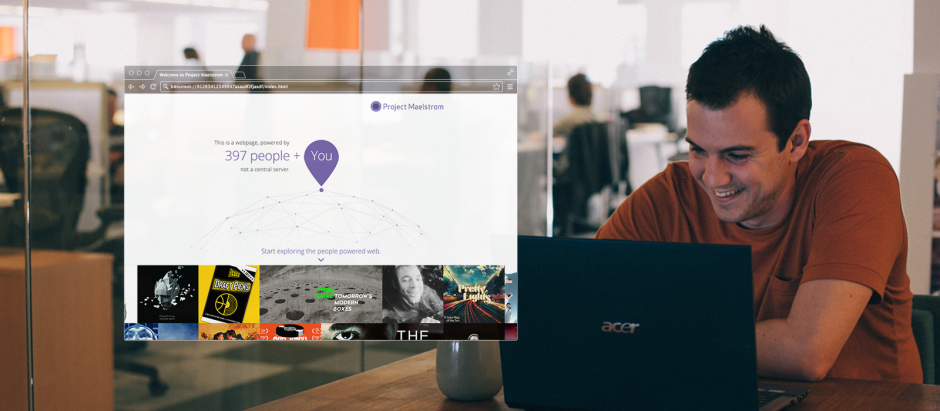

Maelstrom est un navigateur qui ambitionne de changer la façon dont le Web fonctionne et apporter un internet plus décentralisé que jamais.

BitTorrent veut repenser la manière dont les internautes interagissent (accès au web, publication des contenus, etc.) et offrir un internet neutre.

« Le projet Maelstrom commence à répondre à cette question avec notre première version publique d'un navigateur Web qui permet de publier, d'accéder ou de consommer du contenu d'une nouvelle manière. Un Internet alimenté par chacun, qui réduit les barrières et repousse ceux qui veulent garder le contrôle et une emprise sur notre futur », explique Eric Klinker, le PDG de la firme dans un billet de blog.

Avec les multiples programmes d’espionnage des gouvernements qui ont été révélés ses dernières années, les défis à relever son important pour garder le web ouvert. « Si nous y parvenons, nous croyons que ce projet aura le potentiel pour résoudre certains des plus gros problèmes auquel Internet est confronté aujourd'hui. Comment garder internet ouvert ? Comment garantir la neutralité d’internet ? Comment pouvons-nous nous assurer que nos données privées sont en sécurité et ne sont pas détournées par des grandes entreprises ? Comment pouvons-nous aider Internet dans son besoin de diffusion de contenus ? », renchérit Eric Klinker.

Pour l’instant, peu d’informations techniques ont été publiées sur le projet Maelstrom. Il n’apportera pas de changement sur la manière dont les contenus sont créés, mais introduira un autre moyen de distribution et de publication des contenus Web.

Le navigateur serait actuellement au stade de version Alpha et pour avoir l’occasion de le tester, vous devez vous enregistrer sur le site du projet.

S'enregistrer pour tester le navigateur

S'enregistrer pour tester le navigateurSource : BitTorrent

Et vous ?

Un tel navigateur pourra-t-il être à l’abri de l’espionnage et maintenir le net neutre ?

Un tel navigateur pourra-t-il être à l’abri de l’espionnage et maintenir le net neutre ?