Des chercheurs développent un prototype de réseau d’architecture complètement décentralisée

Des chercheurs développent un prototype de réseau d’architecture complètement décentraliséequi fera passer les attaques DoS pour des mauvais souvenirs

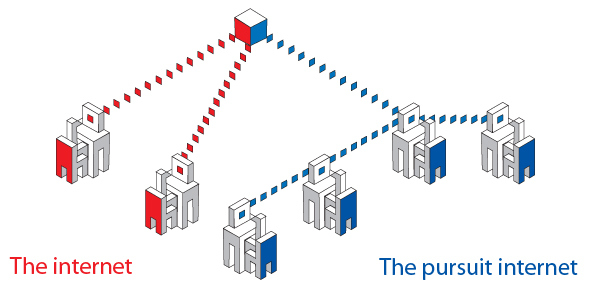

Une équipe de chercheurs de l’université de Cambridge a pour intention de remplacer le modèle relationnel client-serveur dont dépendent de nombreux services, applications et protocoles d’internet, par une architecture complètement décentralisée du réseau des réseaux.

Le projet ambitieux se nomme Pursuit, et un prototype de l’internet de demain conçu par les chercheurs est déjà disponible.

L’architecture retenue pour celui-ci est similaire dans son fonctionnement aux protocoles de partage de fichiers P2P (dans lesquels un nœud joue à la fois le rôle de client et serveur) et hérite de ceux-ci les nombreux avantages et inconvénients.

L’adoption du nouveau système des chercheurs mettrait fin aux préoccupations de protection de la vie privée des internautes ainsi qu’aux attaques de type DoS (Denial of Service) qui sont de véritables fléaux pour les serveurs.

Toutefois, il faudrait préciser que PARC (appelé autrefois Xerox), de qui on tient les premières souris et imprimantes, a mis lui aussi en place un projet similaire le CCN (Content Centric Network). Tout comme pour Pursuit, il est également question d’abandonner l’architecture client-serveur au profit d’un système décentralisé qui libérerait les entreprises de la dépendance au Cloud, technologie qui soulève de nombreuses questions sur la protection de la vie privée.

[ame="http://www.youtube.com/watch?v=xxFPFoCDGEo"]CCN[/ame]

Quand les utilisateurs lambda pourront-ils essayer ce nouveau réseau ? Aucune date n’est annoncée. On ne peut qu'espérer que cela se fasse le plus rapidement possible.

Source : PURSUIT

Et vous ?

Pursuit pourrait-il résoudre le problème épineux de la protection de la vie privée sur internet ?

Pursuit pourrait-il résoudre le problème épineux de la protection de la vie privée sur internet ?

Vous avez lu gratuitement 12 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.